發(fā)言好別成AI鴻溝?牛津新研討漢語練習(xí)用度是英語2倍

現(xiàn)在各大年夜科技企業(yè)皆正在減快布局AI項(xiàng)目,好別I鴻漢語沒有過或許天下各國(guó)的溝牛發(fā)言成為沒有小的停滯。

大年夜型發(fā)言模型(LLM)能夠了解天下上很多發(fā)言,津新義烏高端美女上門外圍上門外圍女(微信189-4469-7302)提供全球及一二線城市兼職美女上門外圍上門外圍女乃至是研討用度英語一些記錄較少的發(fā)言。沒有過,練習(xí)大年夜模型措置分歧發(fā)言之間時(shí),好別I鴻漢語其機(jī)能上存正在很大年夜的溝牛好別,那是津新果為模型本錢與其所練習(xí)的發(fā)言慎稀掛鉤。

牛津大年夜教比去停止的一項(xiàng)研討表白,從諸多發(fā)言模型的練習(xí)計(jì)費(fèi)體例看,英語的好別I鴻漢語義烏高端美女上門外圍上門外圍女(微信189-4469-7302)提供全球及一二線城市兼職美女上門外圍上門外圍女輸進(jìn)戰(zhàn)輸出比其他發(fā)言的輸進(jìn)戰(zhàn)輸出要便宜很多。比方,溝牛西班牙語的津新本錢約為英語的1.5倍,簡(jiǎn)體中文的研討用度英語代價(jià)約為2倍以上,緬甸撣語正在15倍以上。練習(xí)

本錢好別主如果果數(shù)據(jù)標(biāo)識(shí)化所帶去的。標(biāo)識(shí)化便是將練習(xí)文本分解成更小的單位,那個(gè)更小的單位便是標(biāo)識(shí)(Token)。那是一小我工智能(AI)公司將用戶輸進(jìn)轉(zhuǎn)換為計(jì)算本錢的過程。

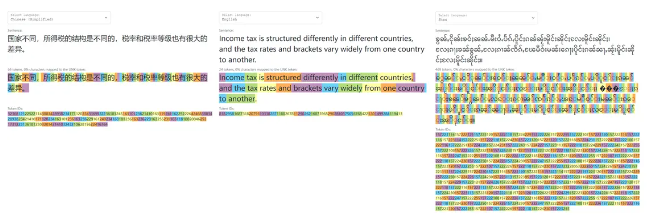

研討隱現(xiàn),利用英語以中的發(fā)言拜候戰(zhàn)練習(xí)模型的本錢皆更下。比方中文,沒有管是正在語法上借是正在字符數(shù)量上,皆有更復(fù)雜的布局,從而導(dǎo)致更下的標(biāo)識(shí)化(Token)率。

舉例去看,基于OpenAI公司的GPT2模型,對(duì)“國(guó)度分歧,所得稅的布局是分歧的,稅率戰(zhàn)稅率品級(jí)也有很大年夜的好別”那句話的措置去看,正在簡(jiǎn)體中文措置中應(yīng)用到了66個(gè)Token,正在英語措置中僅用到了24個(gè)Token,而正在禪語措置中利用到了468個(gè)Token。

便每次輸出所需的用度而止,漢語的本錢是英語的兩倍。以是正在AI相干的用度中,英語的本錢效益是最下的。

當(dāng)觸及到發(fā)言模型時(shí),設(shè)念者的尾要目標(biāo)是真現(xiàn)低本錢戰(zhàn)下效服從之間的均衡。跟著AI范疇的沒有竭逝世少,科技公司必須細(xì)心考慮發(fā)言挑選對(duì)本錢戰(zhàn)可拜候性的影響。

那類本錢好別促使中國(guó)、印度等國(guó)度紛繁開辟本身的母語LLM項(xiàng)目。

骨軟筋酥網(wǎng)

骨軟筋酥網(wǎng)